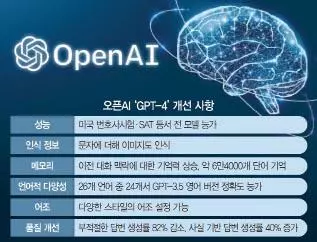

오픈AI ‘GPT-4’ 공개

지난해 11월 공개 후 전 세계에 생성형 인공지능(AI) 열풍을 불러온 생성형 AI 챗GPT가 더욱 발전된 언어모델을 품고 훨씬 강력해진다.

챗GPT 개발사 오픈AI는 14일(현지시간) 챗GPT에 쓰인 AI 언어모델 GPT-3.5의 차세대 버전인 ‘GPT-4’를 공개했다. 경쟁사인 구글이 출시를 예고한 AI 챗봇 ‘바드’(Bard)가 아직 등장조차 못 한 상황에서, 오픈AI가 한 단계 진화한 모델을 선보인 것이다. 챗GPT 데뷔 후 불과 4개월 만의 업그레이드다.

자동차로 치면 엔진에 해당하는 AI 언어모델은 다양한 상품 제작의 기반이 된다. 언어모델을 가지고 이용자와 사람처럼 대화를 주고받을 수 있도록 만든 게 바로 챗GPT다. 언어모델이 검색엔진에 활용된 사례는 마이크로소프트(MS)의 ‘빙’(Bing)이고, 스냅은 이를 모바일 메신저에 채용했다.

오픈AI는 신모델 GPT-4가 ‘인간에 가까운 수준의 능력’을 보인다고 밝혔다. 평소 대화에서는 GPT-3.5와 큰 차이를 못 느낄 수 있지만 “훨씬 더 신뢰할 수 있고 창의적이며 미묘한 명령까지 처리할 수 있다”는 게 오픈AI의 설명이다.

오픈AI가 공개한 두 모델의 각종 테스트 결과를 보면 GPT-4의 뛰어난 성능이 분명하게 확인된다. 앞서 GPT-3.5는 미국 변호사시험에서 100명 중 하위 10%에 해당하는 성적을 받았지만, GPT-4는 상위 10%에 들었다고 한다. 미국의 수학능력시험 격인 대학입학자격시험(SAT) 수학 시험에서도 GPT-3.5보다 높은 성적을 얻었다.

이용자가 체감할 수 있는 GPT-4와 GPT-3.5의 가장 큰 차이는 이미지 인식 여부다. 문자만 인식 가능했던 기존 버전과 달리 GPT-4는 이미지도 보고 이해할 수 있다고 한다. GPT-4에 많은 풍선이 줄에 연결돼 있는 사진을 제시하고 “줄을 자르면 무슨 일이 일어날까?”라고 물으면 “풍선들이 날아간다”고 답하는 식이다. 웃긴 사진을 주고 “이게 왜 웃긴 건지 설명해 달라”고 물어도 GPT-4는 사진 속 ‘맥락’을 이해하고 대답을 내놓는다.

오픈AI는 이 기능을 시각장애인 보조 애플리케이션(앱)을 개발한 비마이아이즈(Be My Eyes)와 함께 테스트 중이다. 이날 비마이아이즈 측이 공개한 예시에 따르면, GPT-4 결합을 통해 구동될 새로운 앱은 이용자가 앱을 이용해 냉장고 내부 사진을 찍으면 뭐가 들었는지 파악해 줄 뿐 아니라, 해당 재료로 만들 수 있는 음식의 조리법을 알려준다.

문자 처리 능력 역시 향상됐다. GPT-3.5는 한 번에 최대 3,000개 단어까지만 처리할 수 있었으나 GPT-4는 2만5,000단어로 능력이 8배나 늘었다.

GPT-4는 또 영어만 잘했던 GPT-3.5와 달리 다른 언어 실력도 뛰어나다고 오픈AI는 밝혔다. 여기엔 한국어도 포함된다. AI 언어모델 성능을 평가하는 시험을 치게 했더니 GPT-3.5는 영어 시험에서 70.1점을 받았는데, GPT-4는 영어 85.5점, 한국어는 77점을 받았다고 오픈AI는 밝혔다.

GPT-4는 GPT-3.5보다 훨씬 더 빠른 속도로 일상 속 다양한 서비스와 결합될 전망이다. 외국어 학습 앱 듀오링고(Duolingo)와 아이슬란드 정부 등이 GPT-4를 활용하기 시작했다. 아이슬란드는 자국어 보존을 위한 번역 서비스를 개발 중이다.

MS도 이날 검색엔진 빙에 GPT-4를 바로 도입했다. 챗GPT의 경우 월 20달러짜리 유료 버전(챗GPT 플러스)에 먼저 적용된다. 무료 버전에도 장착될 예정이나 시기는 미정이다.

<이서희 특파원 >

![[관세 위법판결] 증시호재 vs 재정폭탄 엇갈린 전문가반응](/image/290752/75_75.webp)